- Autorius Lynn Donovan donovan@answers-technology.com.

- Public 2023-12-15 23:50.

- Paskutinį kartą keistas 2025-01-22 17:32.

1) Mažos failo problemos in HDFS : Daug saugoma mažus failus kurios yra itin mažesnis nei bloko dydis negali būti efektyviai valdomas HDFS . Perskaitymas mažus failus apima daug ieškojimų ir daug peršokimų tarp duomenų mazgo į duomenų mazgą, o tai yra neefektyvus duomenų apdorojimas.

Be to, kurie failai sprendžia mažas „Hadoop“failų problemas?

1) HAR ( Hadoop archyvas) Failai buvo supažindintas su spręsti mažų failų problemą . HAR įvedė sluoksnį viršuje HDFS , kurie suteikia sąsają failą prieiga. Naudojant Hadoop archyvo komanda, HAR failus yra sukurti, kuri veikia a MapReduce darbas supakuoti failus yra archyvuojamas mažesnis skaičius HDFS failai.

Be to, ar galiu turėti kelis failus HDFS naudojant skirtingus blokų dydžius? Numatytas dydis apie blokas yra 64 MB. tu gali pakeiskite jį pagal savo poreikius. Prie tavo klausimo taip tu gali sukurti kelis failus varijuojant blokų dydžiai bet realiuoju laiku tai valios nepritaria gamybai.

Be to, kodėl HDFS optimaliai netvarko mažų failų?

Problemos su mažus failus ir HDFS kas failą , katalogas ir blokuoti HDFS yra vaizduojamas kaip objektas vardinio mazgo atmintyje, kurių kiekvienas užima 150 baitų, kaip nykščio taisyklė. Be to, HDFS nėra pritaikyta efektyviai pasiekti mažus failus : tai yra pirmiausia skirtas didelės apimties srautinio perdavimo prieigai failus.

Kodėl „Hadoop“veikia lėtai?

Lėtas Apdorojimo greitis Šis diskas ieško užtrunka, todėl visas procesas yra labai didelis lėtas . Jeigu Hadoop apdoroja duomenis nedideliu kiekiu, tai labai lėtas palyginti. Tai idealiai tinka dideliems duomenų rinkiniams. Kaip Hadoop Pagrindinis yra paketinio apdorojimo variklis, kurio greitis apdorojimui realiuoju laiku yra mažesnis.

Rekomenduojamas:

Kokią problemą išsprendžia strategijos modelis?

Strateginis modelis naudojamas sprendžiant problemas, kurios gali būti (arba numatomos, kad jos gali būti įgyvendintos arba išspręstos) skirtingomis strategijomis ir kurios turi aiškiai apibrėžtą sąsają tokiems atvejams

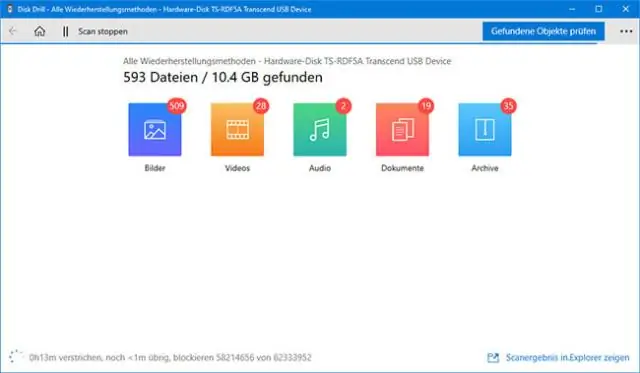

Kas yra failų ir failų organizavimas?

Failų organizavimas reiškia loginius ryšius tarp įvairių failą sudarančių įrašų, ypač identifikavimo priemonių ir prieigos prie bet kurio konkretaus įrašo atžvilgiu. Paprastais žodžiais tariant, failų saugojimas tam tikra tvarka vadinamas failų organizavimu

Kokie yra skirtingi „Hadoop“failų formatai?

Jūsų laimei, didžiųjų duomenų bendruomenė iš esmės apsisprendė prie trijų optimizuotų failų formatų, skirtų naudoti Hadoop klasteriuose: optimizuotas eilučių stulpelis (ORC), „Avro“ir „Parquet“

Kas yra failų parašai arba failų antraštės, naudojami skaitmeninėje kriminalistikoje?

Failų tipai Failo parašas yra unikali identifikavimo baitų seka, įrašyta į failo antraštę. „Windows“sistemoje failo parašas paprastai yra pirmuosiuose 20 failo baitų. Skirtingi failų tipai turi skirtingus failų parašus; pavyzdžiui, Windows Bitmap vaizdo failą (

Kokia yra DOS svarba diskutuoti apie failų sistemą DOS?

DOS arba MS-DOS buvo svarbi, nes tai buvo priemonė, leidžianti kurti ad hoc paketinius (*. bat) failus arba programas, kurios galėtų būti automatizuotos. DOS komandų eilutės sąsaja taip pat leido naudoti komandas su jungikliais (atributais), kad galėtumėte sąveikauti su kompiuterio ištekliais (pvz., Failų valdymu ir pan.)